Apple acaba de anunciar su próximo gran evento, al que la compañía ha llamado Let Loose, y todo apunta a que los nuevos modelos de iPad serán el principal anuncio de la feria del 7 de mayo. Pero Tim Cook se lanzó a la plataforma de redes sociales para provocar un nuevo accesorio para iPad: una nueva versión del Apple Pencil.

En su mensaje, el CEO de Apple nos pidió «¡designarnos para el 7 de mayo!». »con un emoji de lápiz después. También hay un vídeo que comienza con una mano sosteniendo un lápiz blanco. Luego pasa a varias interpretaciones artísticas del logo de Apple dibujado en lo que podría ser la pantalla de un iPad. Esto termina con el lápiz óptico volviendo a caer en la mano digital.

¡Inscríbenos para el 7 de mayo! ✏️ #AppleEvent pic.twitter.com/1tvyB7h45023 de abril de 2024

Entre la mención de la palabra lápiz, el emoji, el lápiz óptico en el video y el video que presenta el logotipo de Apple creado digitalmente, Cook parece sugerir que algo relacionado con el Apple Pencil aparecerá en el evento del 7 de mayo.

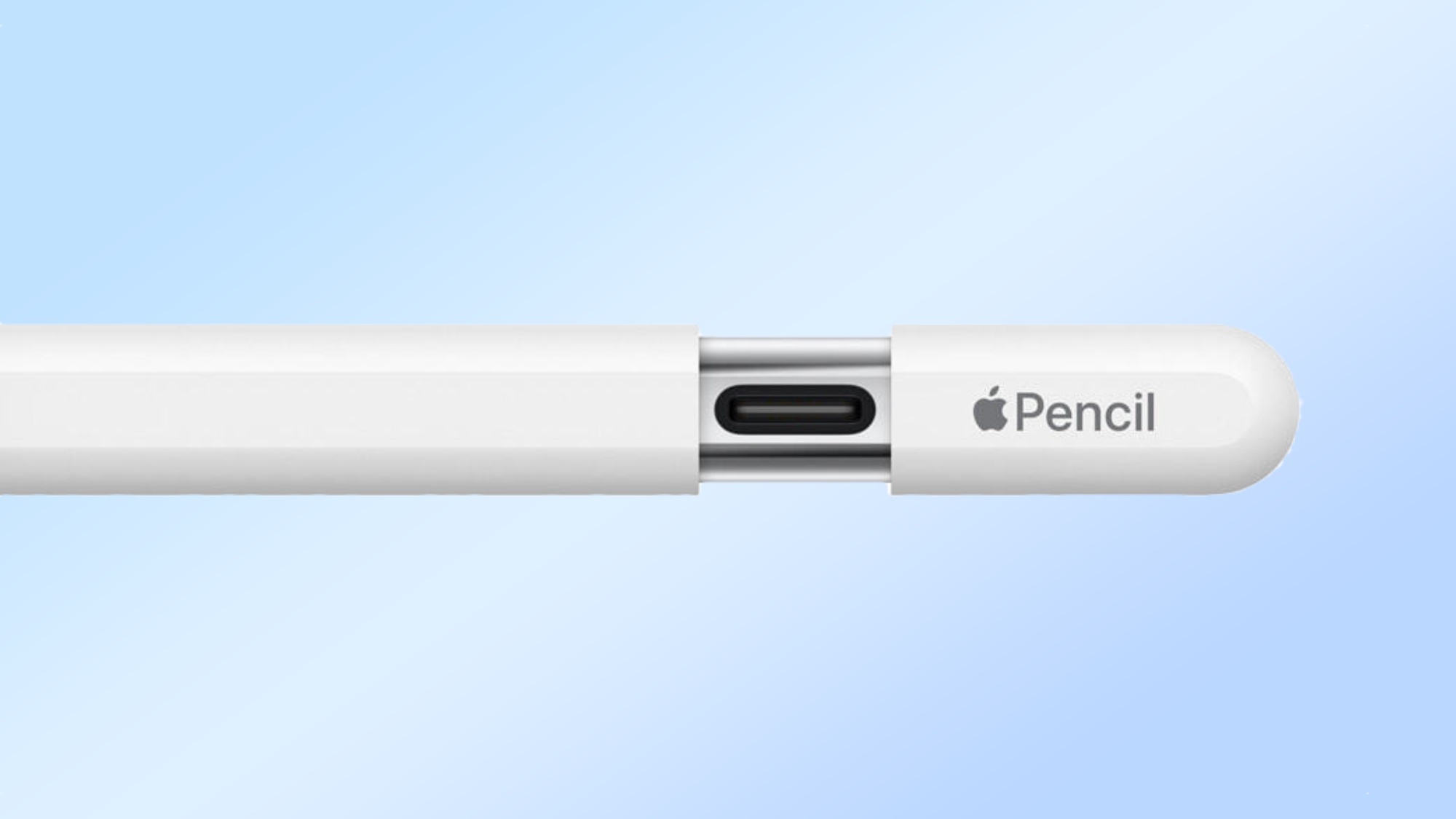

Dado que el Apple Pencil de segunda generación se lanzó en 2018, definitivamente es hora de que Apple lance un nuevo modelo en forma de Apple Pencil 3. (Un modelo USB-C lanzado en 2023, pero no fue una actualización completa) .

El Apple Pencil 2 trajo mejoras inteligentes con respecto al original, incluido un diseño mate, un agarre más cómodo, un gesto de doble toque y carga magnética. Entre estas y las funciones que ofrece el Apple Pencil original, parece que Apple ha cubierto la mayoría de las funciones que podría esperar de un lápiz óptico. Será interesante ver qué aporta la compañía al Apple Pencil de tercera generación.

Hasta ahora hemos escuchado rumores sobre la integración de Find My y puntas magnéticas intercambiables. un informe de 9To5Mac sugiere que el último Apple Pencil podría agregar un gesto de toque a su conjunto de funciones.

Si bien se espera que los últimos modelos de iPad se roben el show en el evento Let Loose, esperamos que cualquier nuevo accesorio para iPad cause sensación. Basado en el revuelo que Cook está tratando de generar en las redes sociales con su anuncio del 7 de mayo.