Ciencia y tecnología

La visión por computadora se acerca al ‘sentido común’ con la última investigación de Facebook – TechCrunch

El aprendizaje automático es capaz de hacer todo tipo de cosas siempre que tenga los datos para enseñarle cómo hacerlo. No siempre es fácil, y los investigadores siempre están buscando una manera de agregar un poco de «sentido común» a la IA para que no tenga que mostrarle 500 fotos de un gato antes de que lo haga. Últimas búsquedas de Facebook da un gran paso adelante para reducir el cuello de botella de datos.

La formidable división de investigación de IA de la compañía ha estado trabajando durante años en cómo avanzar y escalar cosas como algoritmos avanzados de visión por computadora, y ha logrado un progreso constante, generalmente compartido con el resto de la comunidad de investigación. Un desarrollo interesante que Facebook ha perseguido en particular es lo que se conoce como “aprendizaje semi-supervisado”.

Por lo general, cuando piensas en entrenar a una IA, piensas en algo como las 500 fotos de gatos mencionadas anteriormente: imágenes que han sido seleccionadas y etiquetadas (lo que podría significar describir al gato, poner una caja alrededor del gato o simplemente decir que ‘hay un gato en algún lugar) para que el sistema de aprendizaje automático pueda configurar un algoritmo para automatizar el proceso de reconocimiento de gatos. Por supuesto, si quieres hacer perros o caballos, necesitas 500 fotos de perros, 500 fotos de caballos, etc. linealmente, que es una palabra que nunca querrás ver en tecnología.

El aprendizaje semi-supervisado, relacionado con el aprendizaje «no supervisado», implica determinar partes importantes de un conjunto de datos sin ningún dato etiquetado. No solo se vuelve salvaje, siempre hay estructura; por ejemplo, imagina que le das al sistema mil oraciones para estudiar y luego muestras 10 más a las que les faltan varias palabras. El sistema probablemente podría hacer un trabajo decente al completar los espacios en blanco basándose en lo que ha visto en los miles anteriores. Pero no es tan fácil de hacer con imágenes y videos, no son tan simples o predecibles.

Pero los investigadores de Facebook han demostrado que, si bien puede que no sea fácil, es posible y, de hecho, muy efectivo. El sistema DINO (que de manera poco convincente significa «Destilación del conocimiento sin etiquetas») es capaz de aprender a encontrar objetos de interés bastante bien en videos de personas, animales y objetos sin ningún dato etiquetado.

Para ello, considera el vídeo no como una secuencia de imágenes a analizar una a una en orden, sino como un todo complejo e interdependiente, como la diferencia entre “una serie de palabras” y “una frase”. Al tratar con el medio y el final del video, así como con el principio, el agente puede tener una idea de cosas como «un objeto con esta forma general va de izquierda a derecha». Esta información se alimenta de otros conocimientos, como cuando un objeto de la derecha se superpone al primero, el sistema sabe que no es lo mismo, basta con tocar estos marcos. Y este conocimiento, a su vez, puede aplicarse a otras situaciones. En otras palabras, desarrolla un sentido básico de significado visual y lo hace con muy poco entrenamiento en nuevos objetos.

El resultado es un sistema de visión por computadora que no solo es eficiente, funciona bien en comparación con los sistemas entrenados tradicionalmente, sino que es más comprensible y explicable. Por ejemplo, si bien una IA que ha sido entrenada con 500 imágenes de perros y 500 imágenes de gatos reconocerá a los dos, realmente no tendrá ni idea de que son similares de ninguna manera. Pero DINO, aunque eso no puede ser preciso, entiende que son visualmente similares entre sí, incluso más que a los automóviles, y que los metadatos y el contexto son visibles en su memoria. Los perros y los gatos están «más cerca» en su tipo de espacio cognitivo digital que los perros y las montañas. Puede ver estos conceptos como pequeños puntos aquí: vea cómo los de un hombre se unen:

Esto tiene sus propias ventajas, de tipo técnico, en las que no entraremos aquí. Si tiene curiosidad, hay más detalles en las publicaciones relacionadas en el blog de Facebook.

También hay un proyecto de investigación adyacente, un método de entrenamiento llamado PAWS, que reduce aún más la necesidad de datos etiquetados. PAWS combina algunas de las ideas del aprendizaje semi-supervisado con el método supervisado más tradicional, esencialmente dando un impulso a la capacitación al permitirle aprender de los datos etiquetados y no etiquetados.

Facebook necesita un análisis de imágenes bueno y rápido, por supuesto, para sus muchos productos relacionados con imágenes de usuarios (y secretos), pero estos avances generales en el mundo de la visión por computadora sin duda serán bienvenidos por la comunidad de desarrolladores para otros propósitos.

Soy un profesional de gestión deportiva con conocimientos adecuados sobre la industria del deporte en España.

Tengo varias habilidades que me han ayudado a trabajar en diferentes sectores del deporte en España, incluyendo eventos deportivos, desarrollo de base para el deporte e infraestructura deportiva.

Ciencia y tecnología

Google Play Store lanza descargas simultáneas de aplicaciones de Android

Después de pruebas intermitentes en los últimos años, Google parece haber implementado ampliamente descargas e instalaciones simultáneas de aplicaciones en Play Store, mejorando la calidad de vida.

Para verlo en acción, instale dos aplicaciones (elija descargas más grandes, como Google Docs, Sheets y Slides) y vea cómo se descargan y luego se instalan simultáneamente en lugar de esperar a que una se complete primero. Puedes seguir su progreso en Play Store y en tu pantalla de inicio, como se muestra en las capturas de pantalla a continuación.

Este comportamiento actualizado solo se activa en instalaciones nuevas, mientras que solo funciona con dos aplicaciones a la vez. (Puede ver cómo una tercera descarga permanece «Pendiente» hasta que se completa algo del primer par). A modo de comparación, la App Store de iOS puede manejar tres descargas e instalaciones simultáneas.

Actualmente, las descargas simultáneas de Google Play no se aplican a las actualizaciones de aplicaciones, lo que sería más útil ya que las actualizaciones son más comunes que las nuevas instalaciones. Con suerte, esto es solo un caso en el que Google Play comienza poco a poco antes de expandirse. Este cambio será útil al configurar un nuevo teléfono o tableta Android.

Estamos viendo este cambio en varios teléfonos y tabletas Pixel que hemos probado con Android 14 y Play Store versión 40.6.31.

Más información sobre Google Play:

FTC: Utilizamos enlaces de afiliados automáticos que generan ingresos. Más.

Soy un profesional de gestión deportiva con conocimientos adecuados sobre la industria del deporte en España.

Tengo varias habilidades que me han ayudado a trabajar en diferentes sectores del deporte en España, incluyendo eventos deportivos, desarrollo de base para el deporte e infraestructura deportiva.

Ciencia y tecnología

Los creadores del corto basado en Sora explican las fortalezas y limitaciones del video generado por IA

Créditos de imagen: niños tímidos

La herramienta de generación de video de OpenAI, Sora, sorprendió a la comunidad de IA en febrero con un video fluido y realista que parece muy por delante de sus competidores. Pero el debut cuidadosamente organizado omitió muchos detalles, detalles que fueron completados por un cineasta al que se le concedió acceso anticipado para crear un cortometraje utilizando a Sora.

Shy Kids es un equipo de producción digital con sede en Toronto que fue seleccionado por OpenAI como uno de los pocos producir cortometrajes principalmente con fines promocionales de OpenAI, aunque tenían una libertad creativa considerable creando una “cabeza de aire”. En un entrevista con el medio de noticias de efectos visuales fxguideEl artista de postproducción Patrick Cederberg describió «realmente usar a Sora» como parte de su trabajo.

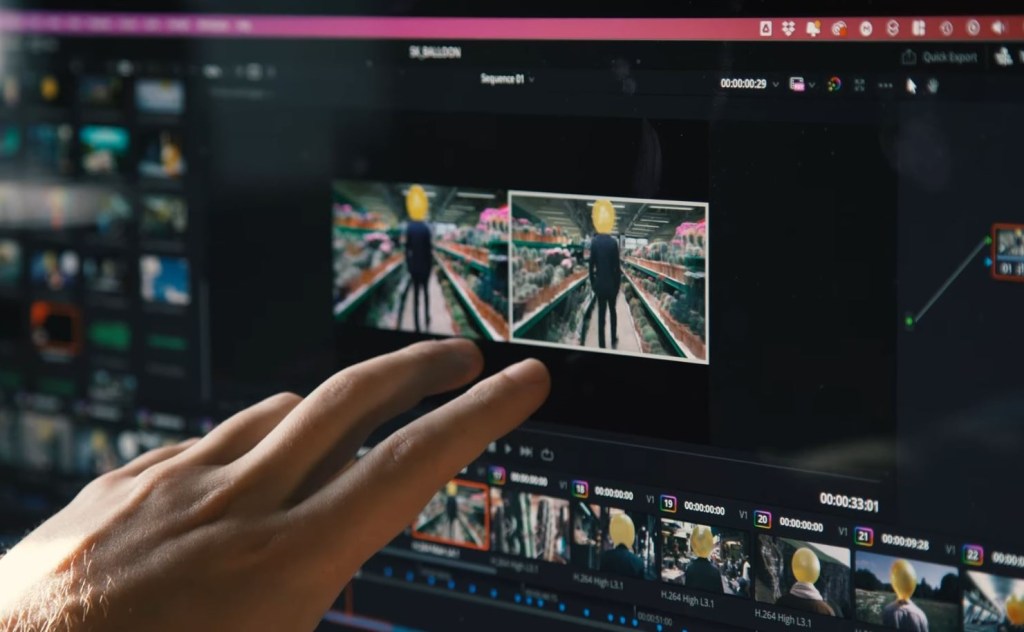

Quizás la conclusión más importante para la mayoría es simplemente esta: aunque el artículo de OpenAI que destaca los cortos deja al lector asumir que surgieron más o menos completamente formados de Sora, la realidad es que se trataba de producciones profesionales, completas con guiones gráficos, edición y corrección de color y trabajos posteriores como rotoscopia y VFX. Al igual que Apple dice «filmado con iPhone» pero no muestra la configuración del estudio, la iluminación profesional y el trabajo de color después del hecho, la publicación de Sora solo habla de lo que permite hacer a las personas, no de la forma en que realmente lo hicieron.

La entrevista de Cederberg es interesante y poco técnica, así que si estás interesado, ve a fxguide y léelo. Pero aquí hay algunas cosas interesantes sobre el uso de Sora que nos dicen que, por muy impresionante que sea, el modelo puede ser un salto menos gigante de lo que pensábamos.

El control sigue siendo en esta etapa lo más deseable y también lo más difícil de alcanzar. …Lo mejor que pudimos conseguir fue ser hiperdescriptivos en nuestras indicaciones. Explicar el vestuario de los personajes, así como el tipo de globo, fue nuestra forma de garantizar la coherencia, porque plano a plano/generación en generación, todavía no existe una función para un control total sobre la coherencia.

En otras palabras, cuestiones simples en el cine tradicional, como elegir el color de la ropa de un personaje, requieren soluciones y controles elaborados en un sistema generativo, porque cada plano se crea independientemente de los demás. Obviamente, esto podría cambiar, pero ciertamente hay mucho más trabajo en este momento.

Los resultados de Sora también tuvieron que ser monitoreados para detectar elementos no deseados: Cederberg describió cómo el modelo generaba regularmente en el globo una cara que el personaje principal tiene como cabeza, o un hilo que colgaba delante de él. Estos tenían que ser eliminados por correo, otro proceso tedioso, si no recibían el mensaje para excluirlos.

Realmente no es posible lograr tiempos y movimientos precisos de los personajes o de la cámara: «Hay un pequeño control temporal sobre dónde suceden estas diferentes acciones en la generación real, pero no es preciso…c «Es una especie de disparo en la oscuridad», Cederberg dicho.

Por ejemplo, cronometrar un gesto como un saludo es un proceso muy aproximado y basado en sugerencias, a diferencia de las animaciones manuales. Y una toma como una panorámica sobre el cuerpo del personaje puede reflejar o no lo que quiere el cineasta, por lo que en este caso el equipo representó una toma compuesta en orientación vertical y recortó en posproducción. Los clips generados también a menudo estaban en cámara lenta sin ningún motivo en particular.

Ejemplo de un disparo como sale de Sora y como acabó en el corto. Créditos de imagen: niños tímidos

De hecho, el uso de lenguaje cinematográfico común como «pan right» o «dolly» era generalmente inconsistente, dijo Cederberg, lo que el equipo encontró bastante sorprendente.

«Los investigadores, antes de acercarse a los artistas para jugar con esta herramienta, en realidad no pensaban como cineastas», dijo.

Como resultado, el equipo ejecutó cientos de generaciones, cada una de las cuales duró entre 10 y 20 segundos, y terminó usando solo unas pocas. Cederberg estimó la proporción en 300:1, pero, por supuesto, probablemente a todos nos sorprendería la proporción en una sesión fotográfica normal.

el equipo en realidad Hice un pequeño video detrás de escena. explicando algunos de los problemas que encontraron, si tiene curiosidad. Como gran parte del contenido adyacente a la IA, Los comentarios son bastante críticos con todo el proyecto. – pero no tan virulenta como la publicidad impulsada por IA que hemos visto ridiculizada recientemente.

La última cuestión interesante se refiere a los derechos de autor: si le pides a Sora que te regale un clip de “Star Wars”, él se negará. Y si intentas eludirlo con «un hombre vestido con una espada láser en una nave espacial retro-futurista», también se negará, porque mediante algún mecanismo reconoce lo que estás intentando hacer. También se negó a hacer un “plano de Aronofsky” o un “zoom de Hitchcock”.

Por un lado, tiene mucho sentido. Pero eso plantea la pregunta: si Sora sabe qué es, ¿eso significa que el modelo fue entrenado en ese contenido para reconocer mejor que está infringiendo? OpenAI, que mantiene sus tarjetas de datos de entrenamiento en secreto, hasta el punto de lo absurdo, como ocurre con Entrevista de la CTO Mira Murati con Joanna Stern – Es casi seguro que nunca nos lo dirá.

En cuanto a Sora y su uso en el cine, es claramente una herramienta poderosa y útil en su lugar, pero su lugar no es «crear películas desde cero». De nuevo. Como dijo otro villano, “eso viene después”.

Soy un profesional de gestión deportiva con conocimientos adecuados sobre la industria del deporte en España.

Tengo varias habilidades que me han ayudado a trabajar en diferentes sectores del deporte en España, incluyendo eventos deportivos, desarrollo de base para el deporte e infraestructura deportiva.

Ciencia y tecnología

El evento iPad 'Let Loose' de Apple también incluirá un evento especial en Londres

Apple celebrará un evento especial el 7 de mayo, durante el cual se espera que «se deje llevar» y lance grandes cambios en la línea iPad. En un giro interesante, parece que también habrá un evento paralelo organizado por Apple en Londres ese día.

¿Un evento de Apple en Londres?

En su cobertura del anuncio del evento de Apple hace unos días, el Independiente incluyó este dato:

Apple retransmitirá el lanzamiento en vídeo en directo en todo el mundo, pero irá acompañado de un evento en Londres, lo que podría explicar el lanzamiento inusualmente temprano. La compañía casi ha realizado sus lanzamientos en California, y hacerlo en el Reino Unido representa una ruptura con la tradición.

Sobre las discusiones, Joe Rossignol dice que «confirmó que Apple organizará una reunión de varios días para conocidos periodistas, blogueros y creadores de contenido de redes sociales en Londres» para el evento «Let Loose» del 7 de mayo.

“Habrá participantes de varios países europeos e incluso de Australia. Creo que se llevará a cabo en Apple Battersea y habrá tiempo práctico con nuevos productos”, dice Joe.

El evento en Londres, por supuesto, será sólo por invitación y no estará abierto al público.

Tomar de 9to5Mac

Para el evento «Scary Fast» de octubre centrado en Mac, Apple no celebró un evento presencial en Cupertino. Sin embargo, invitó a la prensa y a influencers a algunas ciudades del mundo para ver el vídeo del evento y familiarizarse con los productos.

Es probable que esto sea lo que suceda en última instancia con el evento “Let Loose” del próximo mes, pero esta vez también con una reunión en persona en Londres. Esto también podría explicar en parte el horario extraño del evento a las 7 a. m. PT/10 a. m. ET, que son las 3 p. m. ET en Londres.

Más que cualquier otra cosa, esto podría ser una señal de que Vision Pro está a punto de debutar fuera de los Estados Unidos. Durante el evento también esperamos el lanzamiento de un nuevo iPad Pro, iPad Air, Magic Keyboard y Apple Pencil.

¡Veremos! Todavía queda poco más de una semana para que sea oficialmente el momento de soltarse…

Seguir oportunidad: Temas, Gorjeo, InstagramY Mastodonte.

Soy un profesional de gestión deportiva con conocimientos adecuados sobre la industria del deporte en España.

Tengo varias habilidades que me han ayudado a trabajar en diferentes sectores del deporte en España, incluyendo eventos deportivos, desarrollo de base para el deporte e infraestructura deportiva.

-

Horoscopo3 años ago

Horóscopo: ¿qué dice tu ascendente para hoy y el fin de semana del 27 de noviembre?

-

Ciencia y tecnología3 años ago

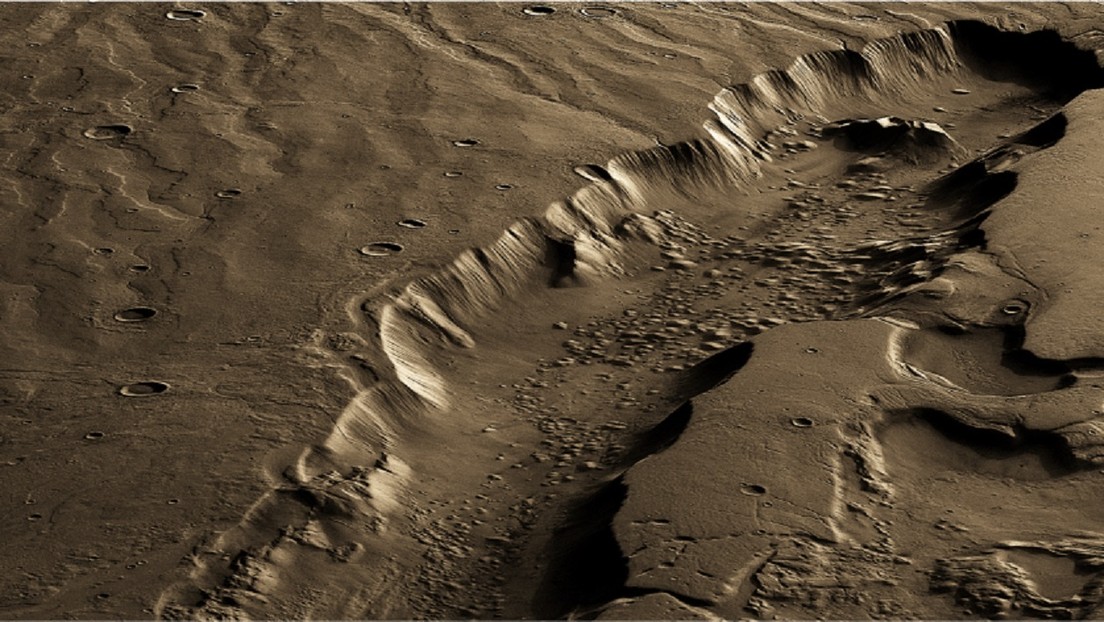

Localizan la región de Marte más apropiada para la existencia de vida.

-

Entretenimiento2 años ago

¿Britney Spears y Sam Asghari están casados? Planes después de la conservación

-

Negocios3 años ago

Reguladores federales investigan bolsas de aire en vehículos 30M

-

Deportes5 meses ago

Vista previa: Perú vs Brasil – predicciones, noticias del equipo, alineaciones

-

Horoscopo3 años ago

Paseo espacial estadounidense fuera de la Estación Espacial Internacional pospuesto debido a un problema médico con el astronauta

-

Entretenimiento3 años ago

Eva Longoria, Shonda Rhimes y Jurnee Smollett abandonan la junta de Time’s Up: «Listos para un nuevo liderazgo»

-

Deportes4 meses ago

Kyogo Furuhashi anota y Japón venció a El Salvador 6-0 en un amistoso | Noticias de futbol