Es 2021 y hasta ahora ha sido una crisis tras otra. Lo que realmente me da esperanza es el tiempo que paso con mi perro. Este es un momento de caos y a menudo me pregunto si mi perro sabe lo que sucede a nuestro alrededor. ¿Nuestras mascotas tienen un sexto sentido para los desastres como lo tienen para nuestras emociones? Los perros son uno de los compañeros domésticos más inteligentes que podemos tener y nuestros amigos peludos realmente forman un vínculo inexplicable con nosotros. Lo que me lleva a esto: ¿cuál es el futuro de los perros robot?

Desprovistos de sentimientos reales, pero con el avance de la IA, seguramente serán más inteligentes y eficientes. Los robots para perros probablemente serán un híbrido entre un animal inteligente y un ayudante doméstico, imagino características como cámaras de seguridad para los ojos y, al mismo tiempo, son lo suficientemente suaves como para llevarte tu diario y despertarte por la mañana. Los robots para perros pueden tener la ventaja de ser de bajo mantenimiento, no requerirán caminatas obligatorias los días de enfermedad ni causarán pánico si se olvida de dejar su comida en una emergencia. Y como puede adivinar, ciertamente no serán una molestia durante la hora del baño.

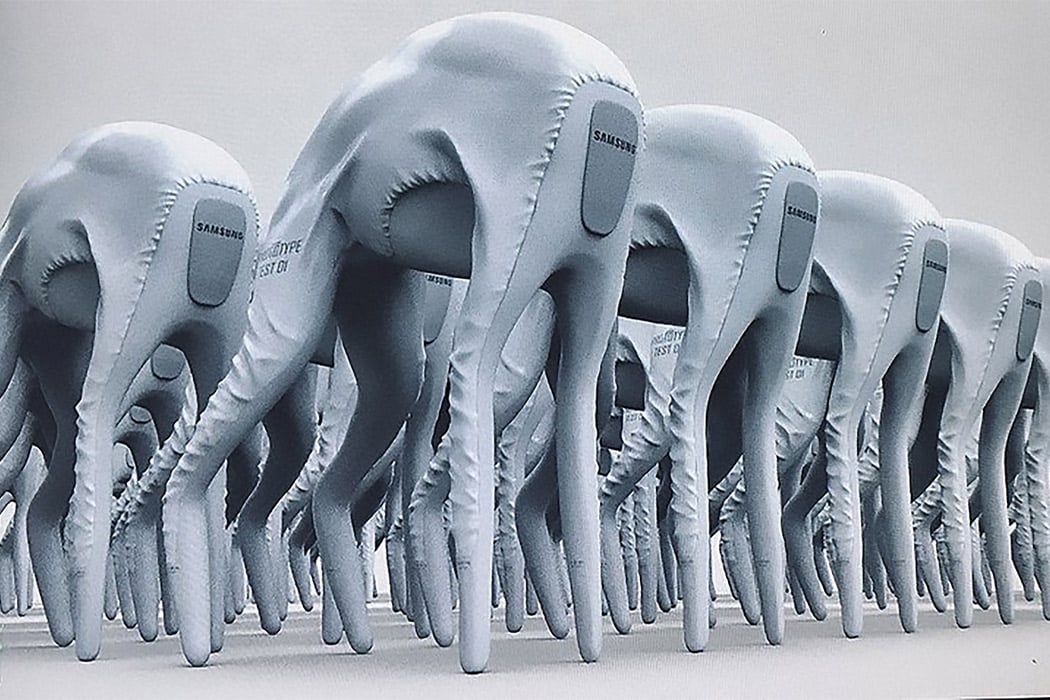

Entonces, para el futuro, esto parece una opción práctica, ya que la IA podrá imitar de cerca el comportamiento de un perro, pero ¿qué pasa con nuestro comportamiento condicionado hacia los perros? Este robot perro conceptual de Samsung reemplaza las características del perro con una pantalla, por lo que en lugar de una cabeza confundida que inclina la cara, también conocida como la pantalla del robot, le mostrará un signo de interrogación. Si los gigantes de la tecnología quieren crear un perro robot, usar una pantalla como interfaz interactiva ahorrará mucho más material que usar materiales similares al plástico para replicar la figura real de su mascota. Con la velocidad a la que se desarrolla la inteligencia artificial y se manifiestan las representaciones conceptuales, el robot perro podrá perseguir las bolas y saludarte rápidamente cuando detecte tu llegada. Es interesante lo futurista que es el diseño y, sin embargo, cuando lo miras puedes darte cuenta de que fue hecho para parecerse a un perro. Es posible que ni siquiera hayas notado que faltaba la « cola » y, sin embargo, nuestros cerebros han evolucionado para asociar la emoción con los robots.

Para la mayoría de nosotros, nuestros perros se consideran familia. El vínculo fuerte nos enseña mucho sobre nuestras propias emociones, el cuidado de los demás en todo momento, la comunicación sin un lenguaje real y el poder invencible de los ojos de cachorro. Si bien la tecnología puede hacer que los robots sean tan realistas que comenzamos a preguntarnos qué es real, algo como un perro que coloca su cabeza en tu regazo nunca puede ser replicado por un robot, ¿verdad? Echemos un vistazo (¿ves lo que hice allí?) Y pensemos en cómo sería la vida si Samsung hiciera un perro robot como este.

Diseñador: Gaetano De Cicco